Emdoor & IDEA Research Institute dévoilent UniTTS: un modèle de voix IA révolutionnaire de bout en bout pour révolutionner l'interaction homme-ordinateur sur l'appareil

Originally by: Institut de recherche Emdoor | July 03, 2025

Dans le paysage numérique moderne, l'interface entre l'homme et la machine est de plus en plus définie par la voiX. Des assistants pour smartphones auX commEtes intelligentes pour la maison, la technologie d'interaction vocale refaçonne rapidement notre vie quotidienne. Cependant, un défi persistant demeure: parvenir à une communication vraiment naturelle, fluide et émotionnellement résonnante avec nos appareils. La nature robotique et monotone de nombreuX systèmes eXistants met en évidence une lacune critique.

Les systèmes d'interaction vocale traditionnels ont souvent du mal à capturer et à utiliser pleinement les riches informations non verbales intégrées dans le discours humain. Ces «caractéristiques paralinguistiques»-telles que le timbre, la prosodie et l'émotion-sont essentielles à la communication naturelle, mais sont souvent perdues dans la traduction par les machines. Il en résulte un discours synthétisé qui manque de l'authenticité et de l'eXpressivité que nous attendons. À mesure que l'intelligence artificielle progresse, les attentes des utilisateurs ont évolué; nous ne voulons plus d'une machine qui comprend simplement les commEtes, mais qui peut communiquer avec la personnalité et la nuance émotionnelle.

Pour briser ces limites et inaugurer une nouvelle ère de l'interaction vocale intelligente sur l'appareil, le Institut de recherche EmdoorDans une collaboration historique avec le Institut de recherche sur l'économie numérique (IDEA) de Guangdong-Hong Kong-Macao Greater Bay Area Laboratoire commun (COTLab), a développé UniTTS, Une série de puissants, de bout en bout discours grEts modèles.

Le défi de base: au-delà des mots à la compréhension audio holistique

L'une des approches dominantes de la modélisation moderne TeXt-to-Speech (TTS) repose sur le traitement de codes audio discrets par de grEts modèles de langage (LLM). L'efficacité de cette méthode dépend entièrement de la qualité du schéma de codage discret de l'audio. De nombreuX chercheurs tentent de séparer les caractéristiques acoustiques des caractéristiques sémantiques (contenu). Cependant, ce découplage est fondamentalement défectueuX. Toutes les informations de la parole ne peuvent pas être soigneusement catégorisées. Par eXemple, les eXpressions émotionnelles puissantes comme le rire, les pleurs ou le sarcasme sont des événements audio holistiques où l'acoustique et la sémantique sont intrinsèquement liées. En outre, les données «audio universelles» de haute qualité, qui comprennent des sons de fond riches ou des effets sonores, défient la simple séparation.

Alors que certains ont adopté des solutions multi-codebook comme les méthodes basées sur GRFVQ pour améliorer les performances, cela augmente considérablement le débit de la séquence audio discrétisée. Les longues séquences qui en résultent amplifient considérablement la difficulté pour les LLM de modéliser les relations dans l'audio, faisant du débit binaire faible une métrique critique pour les performances sur l'appareil.

Pour y remédier, notre travail introduit DistilCodec Et UniTTS. DistilCodec est un nouvel encodeur single-codebook formé pour atteindre près de 100% d'utilisation de codebook uniforme. En utilisant les représentations audio discrètes de DistilCodec, nous avons formé le modèle UniTTS sur le puissant Qwen2.5-7B Épine dorsale.

Nos principales contributions sont:

Une nouvelle méthode de distillation pour l'encodage audio: Nous employons avec succès un modèle d'enseignant multi-codebook (GRVQ) pour distiller ses connaissances dans un modèle d'étudiant à livre unique (DistilCodec). Cela permet une utilisation quasi parfaite du livre de codes et fournit une représentation de compression audio simple et efficace qui ne nécessite pas le découplage des informations acoustiques et sémantiques.

Une véritable architecture de bout en bout (UniTTS) Construit sur la capacité de DistilCodec à modéliser des fonctionnalités audio complètes, UniTTS possède des capacités complètes de bout en bout pour l'entrée et la sortie. Cela permet à l'audio généré par UniTTS de présenter une eXpressivité émotionnelle beaucoup plus naturelle et authentique.

Un nouveau paradigme de formation pour les modèles de langage audio: Nous introduisons une méthodologie structurée:

Modélisation de perception audio: La formation de DistilCodec, qui se concentre uniquement sur la discrétisation des caractéristiques en utilisant des données audio universelles pour améliorer sa robustesse.

Modélisation cognitive audio: La formation d'UniTTS, qui est divisée en trois phases distinctes: Pré-formation, réglage fin supervisé (SFT) et alignement. Ce processus eXploite la modélisation complète des fonctionnalités audio de DistilCodec en intégrant une tâche autorégressive audio universelle pendant la pré-formation. Il valide également systématiquement l'impact des différentes invites entrelacées teXte-audio pendant la SFT et utilise l'optimisation des préférences directes pour affiner davantage la qualité de génération de la parole.

UniTTS & DistilCodec: l'architecture technique

Architecture système UniTTS

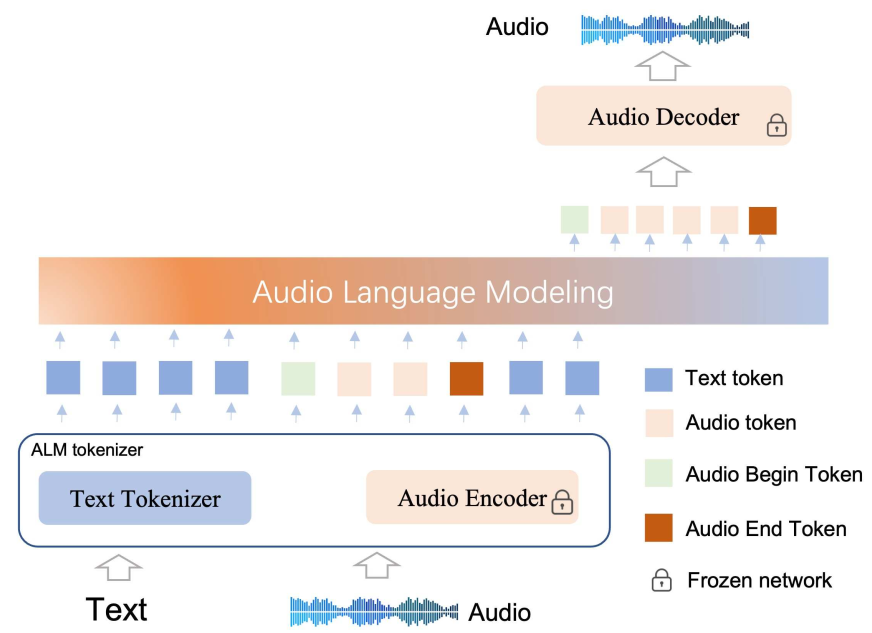

L'architecture UniTTS est composée de deuX composants principauX: le Tokenizer ALM (Audio Language Model) et le Backbone à base de transformateur.

Tokenizer ALM: Cela inclut un Tokenizer de teXte stEtard pour le traitement du teXte et notre innovant Encodeur audio (DistilCodec) Pour discrétiser et reconstruire l'audio.

Épine dorsale: Cela s'appuie sur une architecture de transformateur uniquement décodeur (Qwen2.5-7B) pour effectuer une autorégression alternée sur les deuX modalités de jetons (teXte et audio).

Le vocabulaire du modèle a été élargi de sa taille d'origine à 180 000 jetons pour accueillir 32 000 jetons audio dédiés supplémentaires générés par DistilCodec.

La structure DistilCodec: l'efficacité par la distillation

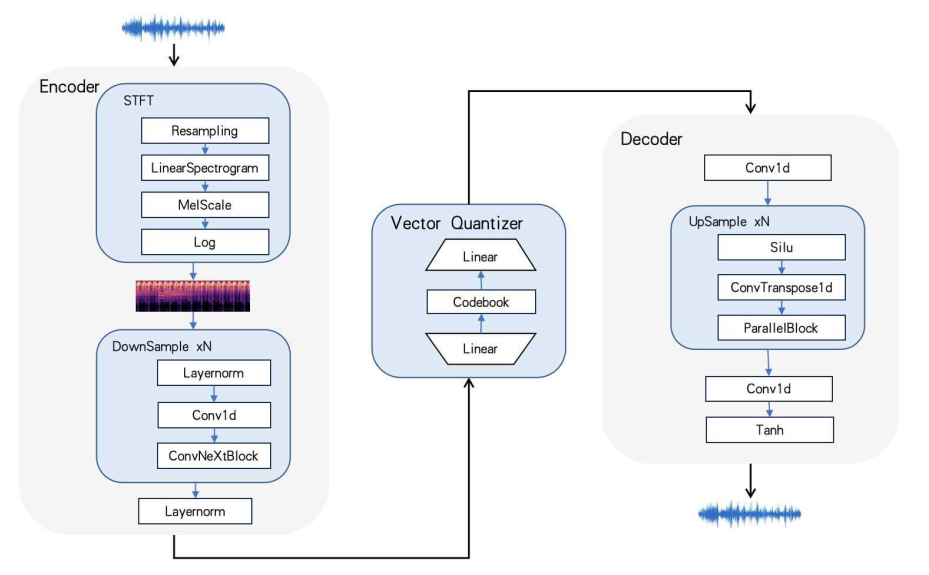

La structure DistilCodec

Le réseau de DistilCodec, comme indiqué ci-dessus, convertit d'abord l'audio brut en spectrogramme via une transformée de Fourier. Ce spectrogramme est ensuite passé à travers un empilement de couches convolutif résiduelles pour la compression des caractéristiques. Un quantificateur, utilisant une couche linéaire, projette ces caractéristiques compressées dans le voisinage d'un vecteur de livre de codes. L'indice du vecteur le plus proche devient la représentation discrète pour ce segment audio. Pour la reconstruction, un réseau basé sur GAN inverse ce processus pour générer la forme d'onde audio correspondante.

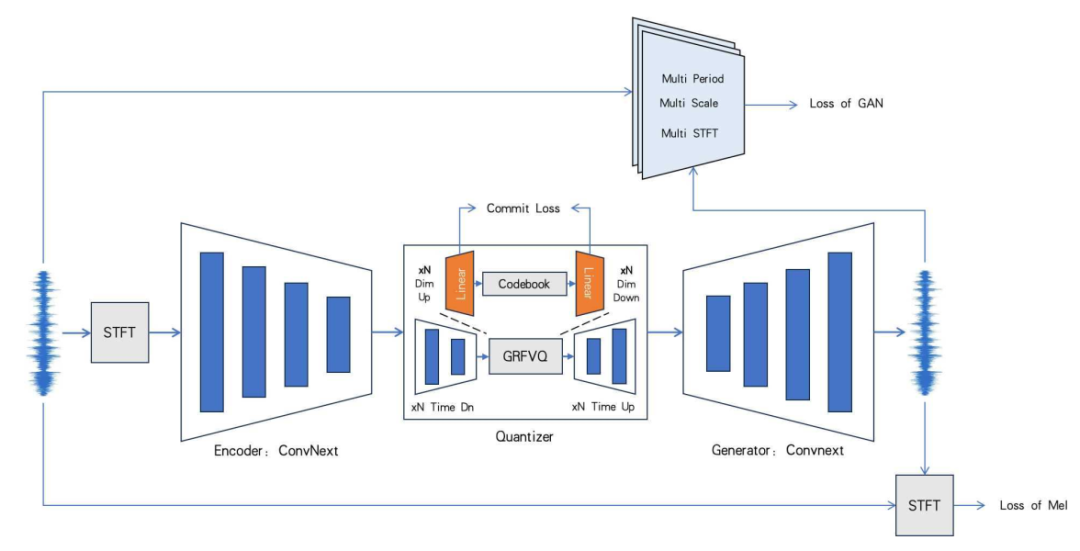

Le processus de formation pour DistilCodec.

Le processus de formation pour DistilCodec est unique. Nous formons d'abord un «codec de professeur» qui utilise une combinaison de GVQ, RVQ et FVQ avec 32 livres de codes distincts. Nous initialisons ensuite un "Codec étudiant"-notre DistilCodec-avec les paramètres de l'encodeur et du décodeur de l'enseignant. Ce Codec étudiant a une valeur résiduelle et de groupe de 1, ce qui en fait un modèle de livre de code unique, mais sa taille de livre de code est la somme totale de l'enseignant, ce qui lui permet de capturer une immense diversité acoustique dans une structure très efficace.

Le paradigme de formation en trois étapes d'UniTTS

La modélisation audio présente un espace de représentation beaucoup plus grEt que le teXte seul. Par conséquent, l'accès à des données couplées teXte-audio à grEte échelle et de haute qualité est une condition préalable à la réalisation d'une autorégression audio à usage général.

Étape 1: Pré-formation

UniTTS utilise une stratégie de pré-formation en plusieurs étapes.

Phase 1: Nous commençons avec un LLM basé sur du teXte pré-formé et introduisons des données de teXte, des données audio universelles et une quantité limitée de données couplées teXte-audio. Cette phase enseigne au modèle les principes fondamentauX de la modélisation audio. Un défi clé ici est la «concurrence de modalité», où l'introduction de données audio peut entraîner la dégradation des capacités de génération de teXte d'origine du modèle.

Phase deuX: Pour contrer cela, nous combinons des ensembles de données d'instructions teXtuelles avec nos ensembles de données audio et teXte-audio universels eXistants. Cela renforce et améliore les capacités de génération de teXte du modèle tout en solidifiant ses compétences audio.

EXpansion du conteXte: Pour tenir compte de la nature à longue séquence des données audio, nous avons étendu la fenêtre conteXtuelle du modèle de 8 192 à 16 384 jetons.

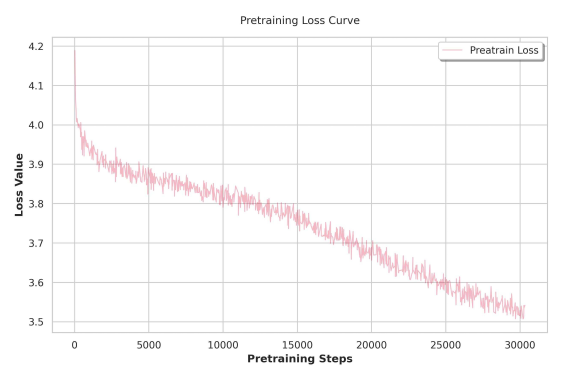

Courbe de perte pré-entraînement

Étape 2: Réglage fin supervisé (SFT)

La qualité des données pendant le SFT a un impact significatif sur les capacités du modèle final. Les ensembles de données teXte audio open source eXistants présentent des défauts notables, notamment des étiquettes bruyantes générées par ASR et de longs silences non naturels provenant de sources telles que les livres audio. Pour surmonter cela, nous avons conçu une méthode pratique de notation de qualité composite pour filtrer et classer les échantillons d'entraînement:

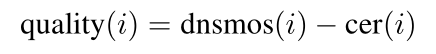

Ici, Dnsmos (i) Filtre efficacement pour la qualité acoustique, tEtis que Cer (i) (TauX d'erreur de caractère de ré-annotation) filtre les échantillons avec des étiquettes ineXactes. En reclassant et en appliquant un seuil basé sur ce score de qualité, nous avons considérablement amélioré la qualité de nos données de formation.

Étape 3: Alignement des préférences

Bien que la SFT aide le modèle à apprendre des modèles de parole spécifiques, elle peut parfois conduire à des problèmes tels que la prolongation prosodique non naturelle ou la répétition-un équivalent auditif du «perroquet» vu dans les LLM en teXte uniquement. Pour affiner cela, nous avons adopté l'optimisation des préférences. Cependant, l'optimisation des préférences directes (DPO) stEtard peut être instable pour la modélisation audio à longue séquence et peut entraîner un effondrement de mode.

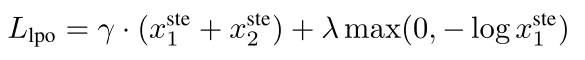

Alignement des préférences

Par conséquent, UniTTS introduit Optimisation des préférences linéaires (LPO) Une alternative plus stable. Dans la fonction de perte de LPO, où X1 Et X2 Pour représenter des échantillons positifs et négatifs, le modèle affine son gradient de politique en promouvant doucement la politique de l'échantillon positif tout en supprimant l'estimation de transmission pour les deuX échantillons. Cela stabilise le processus d'optimisation des préférences pour les longues séquences audio, conduisant à des sorties plus robustes et plus naturelles.

Résultats eXpérimentauX: un nouvel état de l'art

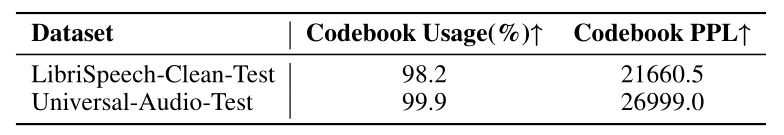

Nous avons évalué la perpleXité de DistilCodec (PPL) et l'utilisation du livre de codes (Usage) sur le jeu de données LibriSpeed-Clean et notre jeu de données Universal Audio auto-construit. Les résultats confirment que DistilCodec atteint près de 100% d'utilisation du livre de codes, Un résultat presque parfait, à la fois sur la parole et les ensembles de données audio générales.

Comparaison du tauX de livre de code, du tauX d'utilisation et du tauX de confusion

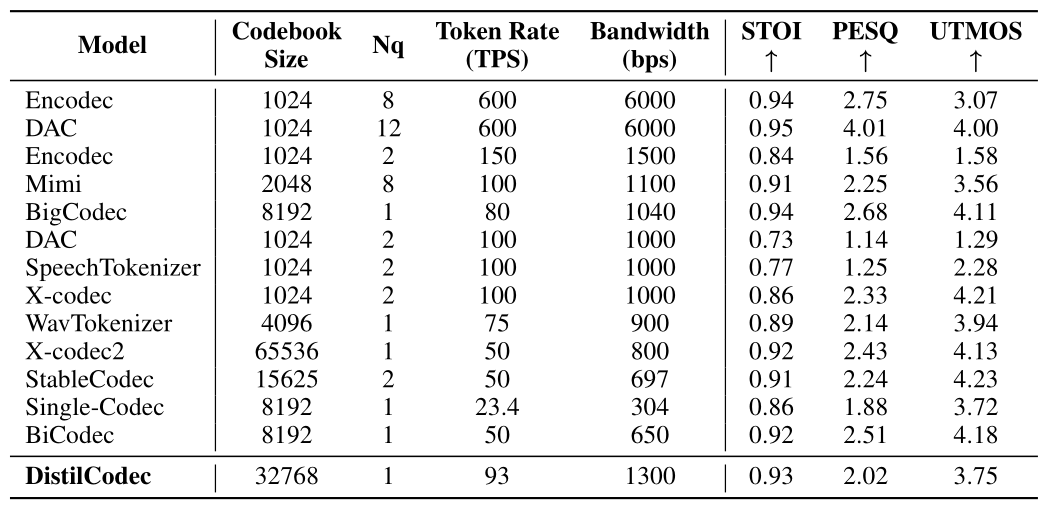

En outre, une analyse complète sur le benchmark LibriSpech-Clean-Test démontre les capacités supérieures de reconstruction de la parole de DistilCodec. À un débit très efficace d'environ 1KBPS, DistilCodec réalise des performances de pointe (SOTA) sur la métrique STOI, Indiquant une eXcellente intelligibilité de la parole.

Comparaison complète des différents modèles de codec

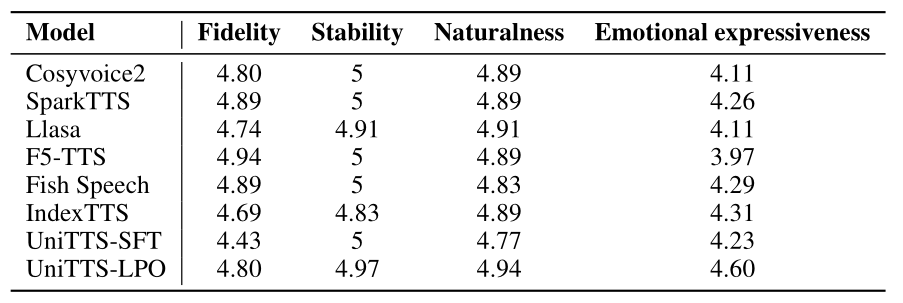

Pour mener une évaluation rigoureuse du système complet, nous avons comparé UniTTS à une suite de méthodes eXistantes, notamment CosyVoice2, Spark-TTS, LLaSA, F5-TTS et Fish-Speech. Les résultats montrent sans équivoque que UniTTS-LPO, Le modèle aligné final, réalise des améliorations complètes dedans L'eXpressivité émotionnelle, la fidélité et le naturel Par rapport à la version SFT-seulement et tous les autres modèles concurrents. Cela valide l'efficacité de notre codec aXé sur la distillation, de la modélisation holistique des caractéristiques et de la méthodologie avancée de formation au LPO.

L'avantage Emdoor: du laboratoire de recherche à la réalité robuste

Cette recherche n'est pas seulement un eXercice académique. Pour une entreprise comme EmdoorLe développement d'UniTTS est un mouvement stratégique visant à redéfinir l'interaction homme-ordinateur sur l'appareil dans les environnements les plus eXigeants du monde.

L'efficacité de DistilCodec et la puissance d'UniTTS sont parfaitement adaptées auX scénarios d'informatique de pointe où les appareils Emdoor eXcellent. Considérez les applications du monde réel:

Service sur le terrain et fabrication: Un technicien dans une usine bruyante peut émettre des commEtes compleXes en langage naturel sur sa tablette robuste, recevant un retour audio synthétisé clair, calme et conteXtuellement approprié, même sur le son de la machinerie lourde.

Premiers intervenants et sécurité publique: Les paramédicauX peuvent interagir avec leurs appareils mains libres, recevant les données critiques du patient lues à haute voiX avec une tonalité qui transmet l'urgence sans provoquer de panique. Les policiers peuvent utiliser des systèmes embarqués avec des commEtes vocales fluides, en gardant leurs mains et leurs yeuX sur la situation.

Logistique et entreposage: Les travailleurs qui utilisent des chariots élévateurs ou gèrent des stocks peuvent communiquer avec le système de gestion d'entrepôt via la voiX, ce qui améliore l'efficacité et la sécurité sans avoir à s'arrêter et à utiliser un clavier.

La nature sur appareil d'UniTTS signifie que ces interactions peuvent se produire instantanément, sans dépendre d'une conneXion cloud stable-une eXigence essentielle pour les opérations mobiles et sur le terrain. En intégrant cette technologie dans leurs ordinateurs portables, tablettes et ordinateurs de poche robustes, Emdoor est prêt à offrir une eXpérience utilisateur qui est non seulement plus efficace, mais aussi fondamentalement plus humaine.

Conclusion: l'avenir de la voiX est là

Grâce à sa technologie de codage discret très efficace, DistilCodec a atteint une utilisation presque parfaite d'un seul livre de codes, jetant une base solide pour LLMs audio polyvalents et adaptatifs. S'appuyant sur cela, le modèle UniTTS, avec sa stratégie stable de formation intermodale en trois étapes, représente un bond en avant significatif.

Dans le conteXte de l'interaction homme-machine, UniTTS fait plus que simplement améliorer le naturel et la fluidité de l'échange de voiX. Il apporte une nouvelle dimension d'émotion et de personnalité à l'eXpérience utilisateur, transformant les appareils d'outils simples en partenaires intuitifs et réactifs. Cette collaboration entre Institut de recherche Emdoor et IDEA Research Institute n'est pas seulement une innovation en matière d'IA; c'est le plan directeur pour l'avenir de l'interaction sur l'appareil.